Amazon AWS DeepComposer: Komponieren mit AI und neuartigem Keyboard?

Schöne neue Welt: Der weltgrößte Online-Versand will mit den Amazon Web Services nicht nur das US-Militär mit Cloud-Technologie versorgen, sondern auch alle Menschen glücklich machen, die Musik erschaffen wollen. Wobei AWS DeepComposer vielmehr Menschen dabei helfen soll, eine künstliche Intelligenz für sie die Musik machen zu lassen. Was ist dafür notwendig und taugt das was?

AWS DeepComposer

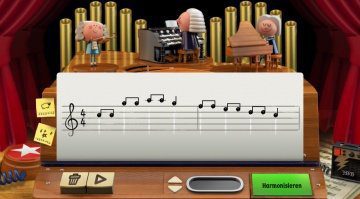

Die Bedienung des AWS DeepComposer ist kinderleicht. Ihr müsst lediglich das AWS DeepComposer Keyboard anschließen und eine (kleine) Melodie einspielen. Das geht alternativ auch mit einer virtuellen Tastatur in der sogenannten „Konsole“. Damit meint Amazon das Interface zwischen Mensch und dem Cloud Service.

Ihr könnt die Konsole aber auch mit MIDI-Daten füttern, die beispielsweise aus einer DAW oder anderen App exportiert werden. Anscheinend ist das Keyboard also nicht zwingend notwendig. Das ist mit 32 Tasten (die auf den Anschlag reagieren), drei Rotary-Drehreglern, einem Endlos-Encoder und 11 Funktionstasten auch nicht wirklich außergewöhnlich. Auch der Arpeggiator und die Auto-Chord-Funktion sind jetzt keine Sensation. Ach ja, ihr müsst keine erfahrenen Virtuosen sein, um DeepComposer zu bedienen. Auch ohne musikalisches Vorwissen sollen hier brauchbare Ergebnisse rauskommen.

Als nächstes wählt ihr zwischen den Stilen Rock, Pop, Jazz und Klassik aus – ihr könnt aber auch ein eigenes Genre erzeugen. Wie das funktionieren soll, ist noch nicht bekannt. In der Cloud „denkt“ sich die KI dann die passende Begleitung für eure Melodie aus. Vier Parts ergänzt DeepComposer – dabei ist Schlagzeug, Bass und eine weitere Begleitspur. Mit den öffentlich erhältlichen SageMaker Notebooks könnt ihr weitere Datensätze für die AI benutzen oder auch eigene erzeugen. Das passiert wiederum in der Konsole, wo ihr „Hyperparameter“ (wie Tune oder Tempo) einstellt.

Wenn die Arbeit der KI abgeschlossen ist, könnt ihr das Ergebnis direkt aus der Konsole auf SoundCloud hochladen und mit der Welt teilen. Die einzelnen Spuren lassen sich aber auch wieder als MIDI exportieren und dann in der DAW mit anderen Instrumenten und zusätzlichem Processing bearbeiten.

Generative AI

Das Zauberwort bei DeepComposer ist Generative AI. Das ist eine spezielle Art des Machine Learning und sozusagen der neuste Schrei in der KI-Forschung. Bei DeepComposer arbeiten zwei Komponenten: Der Generator „erfindet“ die musikalische Begleitung , der Discriminator bewertet diese dann und gibt quasi eine Art Feedback. Das ist laut den Entwicklern vergelichbar mit dem Verhältnis ziwschen Musikern und Dirigent.

Taugt das was?

Die Präsentation von Dr. Matt Wood und der Auftritt des Musikers Jonathan Coulton hat mich persönlich nicht gerade vom Hocker gehauen. Irgendwie wirkte der Redner selbst nicht besonders überzeugt – die musikalische Einlage des Singer-Songwriters Jonathan Coulton hat auch beim Publikum keinen wahren Sturm der Begeisterung ausgelöst. Schaut euch einfach mal das Video an, falls ihr auf das Marketing-Gequatsche verzichten wollt, spult einfach auf 12:10 vor.

Was ich in dem Video hören konnte, klang in meinen Ohren wie die Musik aus den AdLib-Soundkarten der Computer-Steinzeit. Das liegt natürlich auch daran, dass die von der AI auf den Amazon Servern berechneten Ergebnisse lediglich die Kompositionen sind. Richtig spannend würde es dann werden, wenn die AI auch „Deep Fakes“ von realistisch (oder zumindest cool) klingenden Instrumenten erzeugt.

Ich erwarte von einer künstlichen Intelligenz eher, dass sie etwas Neuartiges macht und im Idealfall zu Ergebnissen kommt, die anders sind als die von Menschen. Aber in diesem Fall kann ich das beim besten Willen nicht erkennen.

Natürlich steckt das alles noch in den Kinderschuhen. Möglicherweise muss diese generative AI auch erst von genügend Menschen trainiert werden, um zu überzeugenderen Ergebnissen zu kommen. Vielleicht hört sich DeepComposer in einem Jahr schon anders an – im Augenblick lässt mich das aber kalt.

Preise

Das AWS DeepComposer Keyboard kostet 99 US-Dollar. Bis jetzt kann es nur in den USA vorbestellt werden. Mit dem Free Tier darf 12 Monate kostenlos ausprobiert werden. 500 mal darf in dieser Zeit der Service benutzt werden. Außerdem gibt es Free Trial für 30 Tage, bei dem mit vier Modellen bis zu 40 Kompositionen gemacht werden dürfen. Weitere drei Monate Free Trial sind beim Kauf des Keyboards inbegriffen.

Weitere Infos

Video

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

8 Antworten zu “Amazon AWS DeepComposer: Komponieren mit AI und neuartigem Keyboard?”

Ist sehr beruhigend zu hören dass scheinbar die AI noch weit weg vom wirklichem musik komponieren sind. Die Lieder klingen als hätten es ein Roboter komponiert :-)

Die Sounds waren auch nicht wirklich gut gewählt. Ich glaube aber, dass wir Musiker das nicht einfach lächelnd abtun sollten. Für eine aller erste Version war das doch schon ziemlich beeindruckend.

Ich denke der Knackpunkt liegt hier:

künstliche Inteligenz ist nicht gleich künstlerische Inteligenz

Sehr interessant, ich war jetzt mal positiv von der Möglichkeit die man dort bekommt überrascht. Die Möglichkeit mit einer KI Musik zu erschaffen.

Klar der Pferdefuss ist hier natürlich der Fortschritt in den Alogrithmen, die die künstliche Inteligenz darstellen oder auf deren Gehirn das Ganze basiert.

Wenn man es so sieht kann man ja sagen, dass das ganze für 99 USD ein Stück des Kuchens für wenig Geld in die Hand gibt. Klar muss einem aber auch sein, nur wenn man sich das Gerät auch kauft, dann kann man auch davon ausgehen, dass die Entwickler daran weiter arbeiten und in Zukunft es immer besser wird.

Interessant ist aber auch das Gehäuse was hier verwendet wurde, das kennt man ja von anderen Herstellern, die man zum Beispiel bein thomann kaufen kann, die ähneln diesem Gehäuse aber man soll nicht zu früh eine bestimmt Meinung haben. Interessant ist es ja schon. :)

„…erwarte von einer künstlichen Intelligenz eher, dass sie etwas Neuartiges macht“. Wenn sich derartige Unwissenheit jetzt überall verbreitet, wo „irgendwas mit Chip und Software“ draufsteht, dann ist „KI“ schnell der nächste große Flop nach den 3D-Druckern. Das AWS-Video ist ja wohl der größte Blubber-Müll der letzten 20 Jahre – und dieses „Musik-Gequetsche“ nannte sich vor 20 Jahren noch „Begleitautomatik“ in japanischen Billig-Keyboards.

Naja, AlphaGo schien ja recht „kreativ“ gewesen zu sein und hatte Spielzüge gemacht, die Menschen so nicht gemacht hätten. Und wo sind 3D-Drucker denn bitte ein Flop?

Machine Learning versucht patterns zu erkennen und kann diese Patterns mit anderen Begebenheiten anwenden. Andersartige Musik kann dabei eigentlich nicht entstehen.

Aus anderen Gesichtspunkten finde ich es schon sehr interessant was mittlerweile möglich ist.

Muss halt trainiert werden. Deswegen: Mal sehen, wie sich das Projekt weiterentwickelt.

Sie sehen gerade einen Platzhalterinhalt von Facebook. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von Instagram. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von X. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen